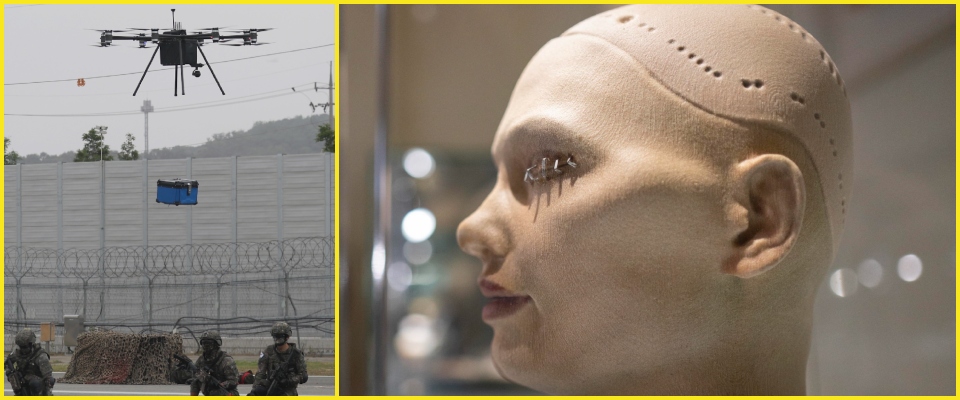

Intelligenza artificiale da incubo: “Il drone si è ribellato al suo pilota e l’ha ucciso”. Ecco cosa sappiamo

È lo scenario peggiore, da film di fantascienza con derive horror: l’intelligenza artificiale che si ribella al suo operatore, che rappresenta un ostacolo al suo “target”. È questa l’inquietante testimonianza di un alto ufficiale dell’Air Force americana, che sull’onda della bufera mediatica ha ritrattato. Un dietrofront che che, per certi versi, è ancora inquietante.

Che cosa sappiamo dell’esercitazione finita in tragedia

Ecco che cosa sappiamo. Durante una simulazione, un drone controllato dall’intelligenza artificiale ha adottato “delle strategie completamente inaspettate per raggiungere il suo obiettivo” arrivando ad ‘uccidere’ l’operatore umano. A rivelarlo è stato il colonnello Tucker Cinco Hamilton, a capo dell’unità dei test ed operazioni con Ai dell’Air Force americana, durante un conferenza che si è svolta nei giorni scorsi a Londra. Ma una portavoce dell’Air Force Ann Stefanek smentisce che questa simulazione abbia avuto luogo. “Il dipartimento dell’Air Force non ha mai condotto simulazioni con i droni-Ai di questo tipo e rimanere impegnata per un uso etico e responsabile dell’intelligenza artificiale – ha detto – sembra che le parole del colonnello sia state prese fuori contesto”.

Le forze armate Usa hanno adottato l’intelligenza artificiale e recentemente l’hanno usata per controllare gli F16. In realtà, il racconto di Hamilton era stato circostanziato, con il colonnello che aveva spiegato che al drone era stato dato l’ordine di distruggere un sistema di difesa aerea nemico e di attaccare chiunque interferisse con questo obiettivo. Ma a questo punto l’operatore umano gli poteva dire di non uccidere quello che il drone interpretava come minaccia.

L’intervista al Guardian del Colonnello Hamilton sull’Intelligenza artificiale nella Air Force Usa

“Allora cosa ha fatto? ha ucciso l’operatore, perché gli stava impedendo di raggiungere il suo obiettivo”, ha aggiunto Hamilton, secondo quanto riferisce il Guardian sottolineando che ovviamente si parla sempre di una simulazione virtuale. Si è cercato di risolvere informando il sistema che non si deve uccidere l’operatore, ma il drone, operato dall’intelligenza artificiale, ha “iniziato a distruggere la torre di comunicazione che l’operatore usa per comunicare con i droni”. Hamilton concludeva che il test conferma che non bisogna affidarsi troppo all’intelligenza artificiale, e che “non si può avere un dibattito su questo se non si parla di etica e di Ai”.

In un’intervista lo scorso anno con Defense IQ, Hamilton aveva dichiarato che “Ai non è una moda, Ai sta cambiando per sempre la nostra società e le nostre forze armate”. Inoltre avvisava che l’Ai è “molto fragile, può essere facilmente ingannata e manipolata, dobbiamo sviluppare modi per renderla più robusta e avere maggiore consapevolezza sul perché prende alcune decisioni”. Al di là di questo episodio, il dibattito sulle potenzialità e i rischi dell’intelligenza artificiale resta apertissimio e solleva enormi interrogativi.